Wie vermutlich den wenigsten unter euch verborgen geblieben ist, habe ich ein Buch über HTML5 geschrieben. HTML5 - Webseiten innovativ und zukunftssicher erscheint bei Open Source Press, hat fast genau 400 Seiten und ist für Leute gedacht, die bereits versierte (X)HTML-Autoren sind und die vorzugsweise auch schon mal die eine oder andere Zeile Javascript geschrieben haben. Grundlagen stehen nur insofern auf dem Programm, als dass ein bisschen die Regeln von HTML ohne X davor rekapituliert werden.

Inhalt

Das Buch richtet sich sowohl an klassische HTML-Autoren als auch alle JS-Nerds, die auf die neuen APIs scharf sind – von Use Cases für <b> bis zu „Hallo Welt“ mit WebGL ist alles dabei. Die Themen auf die im einzelnen eingegangen wird sind die Folgenden:

- Semantisches HTML5

- HTML5-Formulare

- Offline-Webanwendungen

<audio>und<video>- Die Drag&Drop-API

- Das Canvas-Element

Detailinfos nebst Kaufoptionen gibt es auf der Website zum Buch, beim Verlag und bei Amazon, das Inhaltsverzeichnis und eine Leseprobe gibt es als PDF zum Download. (Bei Amazon heißt es zur Zeit, das Buch sei noch nicht erschienen. Das ist falsch! Amazon spielt nur mal wieder Saftladen. Woanders wird bereits fleißig geliefert.)

Zu jedem Thema sind umfangreiche Tabellen und Referenzen sowie nützliche Codesnipsel enthalten (wie zum Beispiel dieses Script zum Auslesen von Custom Data in HTML5-Dokumenten). Es war mir auch sehr wichtig, die Hintergründe von HTML5 zu beleuchten, so dass es neben einem historischen HTML-Exkurs auch ein Extra-Kapitel nur für Kritik an HTML5 und Überlegungen zu Alternativen und der Zukunft des WWW gibt.

FAQ

- HTML5 soll doch erst 2022 fertig sein! Jetzt schon ein Buch darüber?

- Ich würde sogar die Prophezeiung wagen, dass HTML5 nie „fertig“ (im Sinne eines etablierten Webstandards wie HTML 4.01) sein wird. Also wann wenn nicht jetzt?

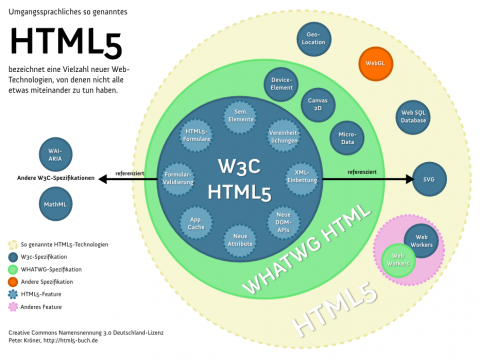

- Die Hälfte von dem was da drinsteht ist doch gar kein HTML5!

- Doch.

- Warum beschreibst du nicht Technologie XYZ?

- Keine Zeit. Das was heute noch fehlt kriegt dann eben in der zweiten Auflage sein eigenes Kapitel. WebWorkers und SVG sind fest für die Zukunft eingeplant.

- Nichts davon geht im IE8!

- Aber hallo, und wie das geht! In vielen Bereichen ist der IE8 sogar besser ausgerüstet als Safari oder Chrome.

- Nichts davon geht im IE6!

- Das ist so pauschal nicht ganz richtig. Man muss nur wissen wie. Und außerdem ist der IE6, wenn nicht schon tot, zumindest schwer komatös. Um den sollte man sich meines Erachtens nicht mehr scheren, wobei ich natürlich spaßeshalber trotzdem den einen oder anderen IE6-Hack im Buch beschreibe.

- Viel zu viel zu lesen!

- Nächsten Monat halte ich eine dreitägige HTML5-Schulung in München. Noch kann man sich anmelden!

- Ich habe eine Frage zu HTML5 oder zum Buch!

- Hier kannst du sie loswerden.

geschrieben haben – High Performance Javascript eben.

geschrieben haben – High Performance Javascript eben.